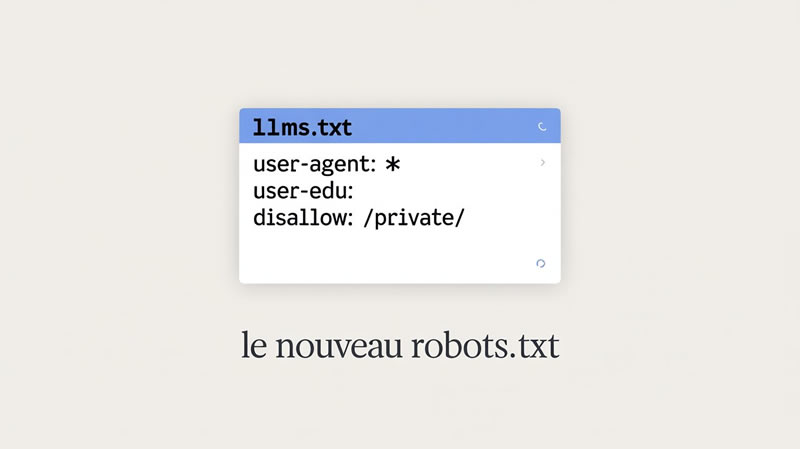

LLMs.txt : le nouveau robots.txt pour les intelligences artificielles ?

LLMs.txt : le nouveau robots.txt pour les intelligences artificielles ?

L’avènement des intelligences artificielles (IA), et notamment des grands modèles linguistiques (LLM), soulève des questions nouvelles concernant la manière dont les données en ligne sont accessibles et utilisées. Tout comme le fichier robots.txt du World Wide Web a établi des règles pour les robots d’exploration traditionnels, une proposition nommée LLMs.txt vise à fournir un cadre similaire pour les ICet article explore ce concept, les défis qu’il cherche à résoudre, ses avantages potentiels, ainsi que ses implications.

Le fichier robots.txt est un texte simple utilisé par les propriétaires de sites web pour indiquer aux robots d’exploration des moteurs de recherche quels éléments d’un site ils ne devraient pas explorer. Il s’agit d’un accord de comportement, une sorte de panneau de signalisation numérique pour les automated crawlers. Cependant, les IA modernes, capables de comprendre et de générer du contenu de manière sophistiquée, représentent une nouvelle catégorie d’entités en ligne. Elles ne se limitent pas à l’indexation pour la recherche. Elles apprennent, analysent et, potentiellement, peuvent utiliser les données d’une manière dont les anciens robots n’étaient pas capables.

LLMs.txt se présente comme une évolution de ce concept. Il proposerait une syntaxe et une structure pour permettre aux sites web de communiquer des directives spécifiques aux ICes directives pourraient aller au-delà de la simple demande de ne pas indexer un contenu. Elles pourraient concerner la manière dont les données doivent être traitées, si elles peuvent être utilisées pour l’entraînement de modèles, ou si certaines sections sont réservées à un usage humain uniquement. Le but est de donner aux propriétaires de sites un moyen plus granulaire de contrôler l’interaction des IA avec leurs informations. L’analogie avec robots.txt est pertinente car elle marque une volonté de structurer et de réguler un flux de données en évolution rapide.

Origines et motivations derrière LLMs.txt

Historiquement, robots.txt a été développé pour éviter de surcharger les serveurs et pour respecter la vie privée des utilisateurs en empêchant l’indexation de certaines pages. Avec les LLM, les enjeux sont différents, mais tout aussi importants. Les LLM apprennent à partir d’énormes quantités de données. Si ces données proviennent de sources non consentantes ou sont utilisées d’une manière non souhaitée, cela peut poser des problèmes de propriété intellectuelle, de confidentialité et de biais. LLMs.txt répond à ce besoin en offrant un mécanisme de communication préventif.

Comparaison avec robots.txt traditionnel

Alors que robots.txt se concentre sur l’exploration et l’indexation pour la recherche, LLMs.txt élargirait le champ pour inclure l’entraînement des modèles, la génération de contenu basé sur des données spécifiques, et potentiellement l’accès à des données pour des tâches d’analyse avancée. Si robots.txt dit « ne pas passer par ici », LLMs.txt pourrait dire « vous pouvez passer, mais pas pour collecter des informations pour votre entraînement » ou « vous pouvez lire, mais pas stocker ce contenu pour une utilisation future ». Les directives seraient plus nuancées, reflétant la complexité des interactions avec les IA.

Les défis posés par les intelligences artificielles pour la gestion des données en ligne

L’essor des IA a rendu la gestion des données en ligne plus complexe. Par le passé, le flux de données était principalement unidirectionnel : les utilisateurs produisaient du contenu et les moteurs de recherche l’indexaient. Les IA introduisent une dimension nouvelle où les données peuvent être consommées, transformées et réutilisées à grande échelle, souvent sans que le créateur original en ait une pleine conscience ou un contrôle.

Le problème de l’entraînement des modèles

Le cœur de la puissance des LLM réside dans leur capacité à apprendre à partir de vastes ensembles de données. Ces données peuvent inclure des textes, des images, du code, etc., provenant de sites web accessibles publiquement. Si un propriétaire de site ne souhaite pas que ses contenus servent de matière première pour entraîner un modèle d’IA, il n’existe actuellement aucun moyen standardisé et facilement applicable de l’exprimer. Les IA, par leur nature, pourraient « lire » et « apprendre » de tout contenu qu’elles rencontrent, sans distinction.

Confidentialité et données personnelles

De nombreux sites web contiennent des informations personnelles ou sensibles. Même si ces informations sont volontairement rendues publiques, leur agrégation et leur analyse par une IA peuvent révéler des patterns ou des corrélations qui n’étaient pas évidents auparavant, potentiellement sans le consentement explicite des individus concernés. L’utilisation potentielle de ces données pour des applications d’IA soulève des préoccupations majeures en matière de vie privée. Le respect de la vie privée, déjà un enjeu avec les moteurs de recherche, devient encore plus critique avec des entités capables d’analyser et de prédire le comportement humain.

Propriété intellectuelle et droits d’auteur

L’utilisation de contenus protégés par le droit d’auteur pour l’entraînement des IA est une zone grise juridique. Les LLM génèrent du texte qui peut ressembler à des œuvres existantes, soulevant la question de la violation du droit d’auteur. Le fait que les données utilisées pour l’entraînement soient obtenues via une exploration web sans consentement spécifique pour cet usage peut être considéré comme une utilisation non autorisée par les créateurs et détenteurs de droits. LLMs.txt pourrait servir de mécanisme pour exprimer des restrictions d’utilisation claires concernant le droit d’auteur.

Transparence et explicabilité

La manière dont les IA traitent les données n’est pas toujours transparente. Les propriétaires de sites web n’ont pas toujours de visibilité sur la manière dont leurs contenus sont utilisés une fois qu’ils sont accessibles. Un fichier comme LLMs.txt pourrait améliorer cette transparence en définissant les types d’accès et d’utilisation autorisés, permettant aux propriétaires de comprendre et de valider comment leurs données sont traitées par les IA.

Face aux défis mentionnés, la nécessité d’un mécanisme de régulation renforcé se fait sentir. LLMs.txt est proposé comme une solution à ce besoin croissant, visant à combler le fossé entre les capacités des IA et les attentes des propriétaires de sites web en matière de contrôle de leurs données. Il s’agit d’une tentative de construire des ponts entre la technologie en évolution rapide et les principes de gestion de l’information établis.

Établir des directives claires et standardisées

Les IA sont développées par une multitude d’acteurs, adoptant diverses approches. L’absence de normes communes rend la régulation difficile. LLMs.txt propose d’établir un langage commun, une grammaire que les IA peuvent comprendre et à laquelle les propriétaires de sites peuvent se référer pour exprimer leurs volontés. Ce standardisation est essentielle pour l’adoption à grande échelle et le respect effectif des directives. Il crée une base sur laquelle des accords plus larges peuvent être construits.

Permettre le contrôle granulaire des données

Les besoins des sites web ne sont pas uniformes. Un blog personnel n’a pas les mêmes préoccupations qu’un site d’actualités ou une plateforme d’e-commerce. LLMs.txt a le potentiel d’offrir une flexibilité nécessaire pour spécifier des règles précises. Par exemple, un site pourrait autoriser l’exploration pour l’indexation des moteurs de recherche, mais interdire l’utilisation de ses contenus pour l’entraînement de modèles d’IA générative. Un autre pourrait permettre un accès limité pour des analyses de tendances, mais pas pour la création de nouveaux contenus qui pourraient concurrencer les siens. Cette granularité est un progrès par rapport à la simple interdiction de passage du robots.txt traditionnel.

Favoriser la confiance et l’adoption responsable de l’IA

En permettant aux créateurs de contenu d’avoir un certain contrôle sur l’utilisation de leurs données par les IA, LLMs.txt pourrait contribuer à bâtir une relation de confiance. Les propriétaires de sites seront plus enclins à autoriser l’accès à leurs données s’ils sentent qu’ils ont un moyen de gérer et de réguler cette utilisation. Cela peut encourager une adoption plus large et plus responsable de l’IA, en évitant la perception d’une technologie invasive et incontrôlable. Le sentiment de contrôle est souvent un préalable à l’acceptation.

Faciliter le respect des politiques de contenu

Chaque site web peut avoir ses propres politiques concernant la diffusion de contenu, la modération, ou la monétisation. LLMs.txt pourrait servir de canal pour communiquer ces politiques de manière opérationnelle aux IPar exemple, une politique interdisant le contenu haineux pourrait être traduite par des directives empêchant les IA de reproduire ou de générer ce type de contenu en se basant sur des exemples présents sur le site, même si ces exemples sont pour des raisons éditoriales d’illustration ou d’analyse.

L’implémentation de LLMs.txt offrirait une gamme d’avantages concrets aux propriétaires de sites web, leur donnant plus de pouvoir dans l’écosystème numérique en pleine mutation. Il s’agirait de leur fournir des outils pour naviguer dans un paysage technologique de plus en plus complexe.

Contrôle accru sur la réutilisation des données

Le bénéfice le plus immédiat serait un contrôle sans précédent sur la manière dont les données d’un site web sont utilisées. Les propriétaires pourraient explicitement interdire ou autoriser l’utilisation de leurs textes, images ou autres contenus pour des tâches spécifiques telles que l’entraînement de modèles d’IA, la génération de résumés, ou la création de contenus dérivés. Cela concerne particulièrement les créateurs de contenu qui dépendent de la valeur unique de leurs œuvres.

Protection de la propriété intellectuelle

Pour les éditeurs, les artistes, les développeurs et tous ceux dont le travail est protégé par le droit d’auteur, LLMs.txt pourrait devenir un instrument de défense. En spécifiant que le contenu ne doit pas être utilisé pour l’entraînement de modèles d’IA, ils peuvent chercher à prévenir la dilution de la valeur de leurs créations et à se protéger contre la concurrence qui pourrait s’appuyer sur leurs œuvres sans autorisation ni compensation. C’est comme si vous pouviez demander à une bibliothèque de ne pas prêter un de vos livres à quelqu’un dont vous savez qu’il va en faire des copies illégales.

Amélioration de la confidentialité

En spécifiant quelles données ne doivent pas être collectées ou analysées par les IA pour des usages non désirés, les propriétaires de sites peuvent mieux protéger la confidentialité de leurs visiteurs. Cela est particulièrement pertinent pour les sites traitant de sujets sensibles ou pour lesquels la protection des données personnelles est une priorité absolue. LLMs.txt pourrait aider à mettre en place des garde-fous numériques pour les informations potentiellement sensibles.

Réduction du risque de biais non désirés

Les IA apprennent souvent à partir de données existantes. Si ces données contiennent des biais, les IA les reproduiront et amplifieront potentiellement. En contrôlant quelles données sont utilisées pour l’entraînement, les propriétaires de sites pourraient indirectement influencer la réduction des biais dans les IA qui interagissent avec leurs contenus. Ils pourraient refuser de rendre disponibles des données qui, une fois analysées, risqueraient de renforcer des stéréotypes ou des discriminations.

Potentiel de monétisation encadrée

À terme, la possibilité d’autoriser l’utilisation de données pour l’entraînement de modèles d’IA pourrait ouvrir des nouvelles voies de monétisation pour les propriétaires de sites web. Si un accord de licence clair est établi, les propriétaires pourraient être rémunérés pour la valeur qu’ils apportent à l’écosystème de l’ILLMs.txt pourrait être le premier pas vers la définition de ces termes.

Simplicité d’implémentation et de compréhension

Comme son prédécesseur robots.txt, LLMs.txt est envisagé comme un fichier texte simple. Cela signifie que son implémentation ne devrait pas nécessiter de compétences techniques avancées. Les propriétaires de sites pourraient le modifier facilement, le rendant accessible à tous, des grandes organisations aux individus.

L’émergence d’un standard comme LLMs.txt ne se limite pas à une simple question technique. Elle soulève des questions juridiques et éthiques profondes qui nécessiteront une réflexion et potentiellement une adaptation des cadres existants. L’élaboration de ces nouvelles règles impacte autant ceux qui créent les IA que ceux qui créent le contenu.

La force juridique des directives

Une question centrale est de savoir quelle serait la force juridique d’un fichier LLMs.txt. S’agit-il d’une recommandation, d’un contrat tacite, ou d’un élément qui pourrait être légalement contraignant ? Si des IA « ignoraient » les directives LLMs.txt, cela pourrait-il constituer une violation de propriété intellectuelle ou de vie privée pouvant être poursuivie en justice ? L’histoire de robots.txt montre que les directives ne sont pas toujours respectées par défaut, et la capacité d’application de LLMs.txt sera clé.

Définition des « robots d’IA » et de leur responsabilité

LLMs.txt vise à réguler les « robots d’indexation » des IMais qu’est-ce qu’un « robot d’IA » au sens juridique ? Est-ce le système d’IA lui-même, le développeur de l’IA, ou l’entité qui déploie l’IA ? Clarifier la responsabilité des différents acteurs sera essentiel pour que des directives telles que LLMs.txt aient un sens pratique et juridique. Identifier le coupable potentiel est une étape cruciale dans toute démarche légale.

Consentement éclairé et droits d’auteur

L’utilisation de données pour l’entraînement de modèles d’IA, même si cela est fait à partir de contenu publiquement accessible, soulève la question du consentement éclairé. Les propriétaires de sites web ont-ils donné leur consentement pour cet usage spécifique ? LLMs.txt pourrait formaliser ce consentement. Cela pourrait avoir un impact majeur sur les litiges en cours et futurs concernant les droits d’auteur et l’utilisation de données pour l’IA.

Éthique de l’utilisation des données et de la création

Au-delà des aspects légaux, il y a une dimension éthique fondamentale. Est-il éthique de construire des systèmes d’IA puissants en utilisant des données, qui sont le fruit du travail et de la créativité d’individus ou d’organisations, sans leur accord explicite ? LLMs.txt peut être vu comme une tentative de rééquilibrer le pouvoir entre les créateurs de contenu et les développeurs d’IA, en privilégiant une approche plus respectueuse et collaborative.

L’impact sur la liberté d’information et l’innovation

Si LLMs.txt devient trop restrictif, il pourrait potentiellement freiner l’innovation et la libre circulation de l’information, qui sont les fondements d’Internet. Il sera crucial de trouver un équilibre entre la protection des créateurs et le besoin de disposer de données abondantes pour le progrès de l’IL’innovation, comme un courant d’eau, a besoin de liberté pour être fertile, mais une régulation adéquate peut éviter les inondations destructrices.

Le succès d’un standard comme LLMs.txt dépendra en grande partie de son adoption par les acteurs majeurs de l’industrie de l’ISans leur coopération, le fichier pourrait rester une proposition théorique sans impact réel. L’adhésion des géants technologiques est donc une condition sine qua non.

Les grands modèles linguistiques et leurs développeurs

Les entreprises qui développent et déploient les LLM les plus influents, tels que Google, OpenAI, Microsoft, Meta, et d’autres, seront en première ligne pour adopter ou rejeter LLMs.txt. Leur décision aura un effet d’entraînement sur les plus petits acteurs du marché. Il est probable que ces entreprises aient déjà des politiques internes concernant l’usage des données, mais un standard ouvert et partagé pourrait harmoniser les pratiques.

Les moteurs de recherche et leurs capacités d’IA

Les grands moteurs de recherche intègrent de plus en plus de fonctionnalités d’IA dans leurs services d’exploration et d’indexation. Ils jouent un rôle crucial dans la manière dont les contenus sont découverts et utilisés. Si LLMs.txt est reconnu par les principaux moteurs de recherche, cela renforcerait considérablement son autorité et son efficacité. Ils peuvent agir comme des relais, assurant que les directives de LLMs.txt sont bien prises en compte par les IA qu’ils utilisent.

Les consortiums et organisations standardisation

Des organismes tels que le World Wide Web Consortium (W3C) pourraient jouer un rôle dans la standardisation et la promotion de LLMs.txt. La participation de ces organisations apporterait une légitimité supplémentaire et aiderait à établir des protocoles clairs et universels. Leur expertise dans l’élaboration de standards web sera précieuse.

Les discussions en cours et les propositions futures

Il est probable que des discussions aient déjà lieu entre les développeurs d’IA, les entreprises technologiques et les défenseurs de la vie privée et des droits d’auteur concernant la nécessité de tels standards. LLMs.txt, bien que proposé ici dans un contexte, est probablement le reflet de discussions et de propositions qui existent déjà ou qui sont en cours de formulation dans les milieux spécialisés. L’adoption ne sera pas un événement unique, mais plutôt un processus graduel.

La nécessité d’une collaboration internationale

Étant donné la nature globale d’Internet et de l’IA, l’adoption de LLMs.txt nécessitera une collaboration à l’échelle internationale. Les divergences réglementaires entre les pays pourraient compliquer une mise en œuvre cohérente. Un effort concerté entre les différentes régions du monde sera nécessaire pour que le standard soit universellement applicable.

L’émergence de LLMs.txt représente une étape potentiellement significative dans la gouvernance des données en ligne à l’ère de l’intelligence artificielle. Alors que robots.txt a établi les bases de la collaboration entre les sites web et les robots d’exploration traditionnels, LLMs.txt vise à adapter ces principes aux capacités et aux usages des grands modèles linguistiques d’aujourd’hui. En offrant un mécanisme standardisé pour que les propriétaires de sites web expriment leurs préférences quant à la manière dont leurs données peuvent être exploitées par les IA, il cherche à apporter un contrôle accru, à protéger la propriété intellectuelle et la vie privée, et à favoriser une adoption plus éthique et responsable de l’IA.

Les défis à relever sont nombreux, notamment en matière de définition de la force juridique des directives, d’application effective par les IA, et de nécessité d’une adoption généralisée par les principaux acteurs de l’industrie. Les implications juridiques et éthiques sont également profondes, soulevant des questions sur le consentement, la responsabilité et l’équilibre entre la protection des créateurs et le progrès technologique. Cependant, l’initiative LLMs.txt incarne un effort louable pour anticiper et gérer les complexités introduites par les IA, en s’inspirant d’un modèle qui a fait ses preuves dans l’histoire du web. S’il est adopté et mis en œuvre de manière réfléchie et collaborative, LLMs.txt pourrait bien devenir le prochain jalon dans la régulation des interactions entre le monde numérique et ses automated inhabitants, assurant ainsi un avenir plus équitable et transparent pour la gestion des données en ligne. Le paysage numérique continue d’évoluer, et la capacité d’adapter nos outils de contrôle à ces évolutions est primordiale pour naviguer sereinement dans ce flux constant de données et d’innovations.

FAQs LLMs.txt : le nouveau robots.txt

Qu’est-ce que LLMs.txt?

LLMs.txt est un nouveau standard proposé pour les fichiers robots.txt, qui sont utilisés par les robots d’indexation pour déterminer quelles parties d’un site web peuvent être explorées et indexées.

Quels sont les défis posés par les intelligences artificielles pour la gestion des données en ligne?

Les intelligences artificielles posent des défis en termes de respect de la vie privée, de sécurité des données et de régulation de l’indexation des contenus en ligne.

Quels sont les avantages potentiels de LLMs.txt pour les propriétaires de sites web?

LLMs.txt pourrait offrir aux propriétaires de sites web un meilleur contrôle sur la manière dont leurs contenus sont explorés et indexés par les robots d’indexation, ce qui pourrait contribuer à une meilleure protection de la vie privée et des données.

Quelles sont les implications juridiques et éthiques de LLMs.txt pour les intelligences artificielles?

L’adoption de LLMs.txt soulève des questions juridiques et éthiques concernant la responsabilité des développeurs d’intelligences artificielles dans le respect des règles de régulation des robots d’indexation.

Qui sont les principaux acteurs de l’industrie de l’intelligence artificielle qui ont adopté LLMs.txt?

Il n’existe pas encore de liste officielle des principaux acteurs de l’industrie de l’intelligence artificielle qui ont adopté LLMs.txt, mais certains moteurs de recherche et développeurs de robots d’indexation pourraient être parmi les premiers à l’adopter.